I detta nummer tar vi upp fler intressanta frågor som: Vad händer just nu inom nätverk? Är det rimligt att serveradmin även ska ha koll på nätverken? Vi pratar också lite ny teknik och hur vi kan göra nät lite enklare och roligare för dig.

Nätverkens PAM4 mot NRZ jämfört med framstegen inom flash-lagring

För fem-sex år sedan var det svårt att tro att flash-lager på 100-talets Tera-eller t.o.m.-Petabyte skulle löna sig, men det inte bara förekommer idag, det är vanligt!

Detta hade inte hänt utan innovation inom NAND-flash. Vi har fått fler minnesceller i varje disk och man packar dessutom betydligt mer data i varje cell idag. QLC lagrar t.ex 8 gånger mer data per cell än SCL.

Nätverkens PAM4-signalering motsvarar NAND-flash övergång från SLC till MLC med dubbelt så många värden i varje överföring jämfört med tidigare NRZ, och detta utan att addera det minsta inom signalledningar och fibrer. Detta ger oss en kostnadseffektiv grund för att erbjuda en attraktiv 100/400 GbE-plattform i samma smidiga format som 25/100GbE.

Servern och nätverket

Även om man ofta separerar serverteknik och nätverksteknik i driftsorganisationen så går ofta framsteg och nyheter inom båda områden hand i hand. Vi som jobbar på Dell Technologies ser detta extra tydligt eftersom vi själva har stora verksamheter inom dessa områden.

Läs vidare så får du se exempel på vad som driver utvecklingen just nu samt konkreta tips som kan öka din insikt i ditt nät.

Från 10/40GbE och 25/100 GbE till 100/400 GbE

Dell satsar stort på 100/400GbE här och nu – snarare än i framtiden. Om vi får välja är standardvalet 100GbE för kommunikation server-till-switch och 400GbE för kommunikation mellan spine- och leaf-switch. Med tanke på hur många som ligger kvar på 10/40GbE, eller nyligen gått över till 25/100 GbE, finns det anledning att förklara hur vi tänker och varför denna övergång är relevant redan idag.

Varför 100/400 GbE?

- Skalbarhet i server och rack: ny och effektivare signalkodning med små, smidiga formfaktorer på anslutningar ger möjlighet till extrem bandbredd. Utan att det leder till stora, otympliga switchar och kableringar.

- NVMe over TCP kommer på bred front när Dell och VMware m.fl. stödjer standarden i såväl server som HCI som lagring. Utöver fördelen att dela nät med övrig servertrafik får vi ett modernt protokoll utvecklat för hög parallellism med intelligent prioriterad hantering, som dessutom är trimmad för att matcha den senaste generationens PCIe och NVMe-enheter. Vi på Serverrummet tycker att den får iSCSI se ut som en kvarleva från anno dazumal, trots att iSCSI fungerar väldigt bra idag.

Har du ett väl fungerande Fibre Channel-nät finns ingen anledning att byta just idag. Men, när det är dags att förnya lagringsnätet: fundera på om det inte vore bättre och enklare med ett 100/400 Gb Ethernet än FibreChannel! - Nyckelinfrastruktur som SDS och HCI på senaste generationens CPU, PCIe och NVMe kräver allt mer bandbredd i de interna nätverken för att matcha styrkan i hårdvaran. Det vi kallar ”east-west”-trafik, d.v.s. kluster- och applikationsintern trafik dominerar den totala nätverkstrafiken och ökar fortfarande.

- Dataanalys och datadrivna insikter samt AI/ML/DL i alla dess former är lika eller ännu mer beroende av ”east-west”-nätverket. Med tanke på de stora summor som investeras varje år inom detta område är kostnaden för ett snabbare nät knappast ett hinder när man planerar för en ny plattform.

Varför 100/400 GbE redan idag?

Effektivitet – färre maskiner kan göra mer med rätt nätverk.

Leveranstid – den extrema komponentbristen inom nätverk gäller i första hand äldre chip medan det ofta finns god tillgång på det nya. Detta gör att leveranstid för 100/400 GbE är den enda nära det normala.

Framtidssäkert – avsevärt minskad risk att vinster med kommande investeringar i hård- och mjukvara hålls tillbaka av begränsad ”east-west”-kapacitet i nätverket.

S5448F-ON multirate ToR/Leaf switch, 1U

Vår mest flexibla switch har 8 st, multi-rate 100GbE-portar och 8 st 400 GbE-portar för t.ex. upplänkar. Den stödjer såväl gamla som nya standarder samt har gott om bandbredd vilket gör det enkelt att skala upp för att klara nya workloads och arbetsmönster i framtiden.

| Band bredd | Signalering | Interface |

|---|---|---|

| 10 GbE | NRZ | SFP+ |

| 25 GbE | NRZ | SFP28 |

| 40 GbE | NRZ | QSFP28 |

| 100 GbE | NRZ | QSFP28 |

| 100 GbE | PAM4 | SFP56-DD |

| 400 GbE | PAM4 | QSFP56-DD |

Switchen har 48 portar för direkt anslutning av 10, 25, 50 och 100 GbE. Med breakout-kablar stöds upp till ytterligare 24 st. 10/25GbE-portar alternativt 16×40/50-eller 32x100GbE med den äldre signaleringstypen.

Vanliga frågor och potentiella fallgropar

- ”Blir det inte dyrt?”

Visst kan nya bandbredder tyckas dyra ut från start, men open source networking med OS10 och SONIC gör det möjligt för oss att endast addera ett mindre påslag mot föregående generation. - ”Vi kan inte byta nät på alla servrar samtidigt”

En serverfarm där man byter 20-25% av enheterna om året behöver stöd under lång tid för såväl gamla som nya nätverksstandarder.

Att bygga två nätverk är inte så attraktivt, men det fina är att det inte behövs när man väljer en bakåtkompatibel switch med stöd för såväl ny som äldre signal- och kontakteringsstandard. - ”Befintliga investeringar i 100 GbE ett hinder”

Flera av våra kunder har varit tydliga med att de gärna går över till effektivare nätverksformat – bara inte de befintliga investeringar gjorda i 100 GbE med den äldre signalstandarden (NRZ) går förlorade.

Här gäller det att välja smart i de fall du behöver en maximalt flexibel lösning. Urvalet är mindre, men utöver bakåtkompatibla switchar finns det idag även nätverkskort till servrar som stödjer både NRZ och PAM4.

Nätverksinsikter och övervakning för serveradmin

Om man som inte jobbar med nätverksadministration på heltid händer det lätt att man fastnar i manualerna när man behöver göra något. Om du känner att mängden information hindrar jobbet är vår kostnadsfria web-tjänst Fabric Design Center något för dig. Lite förenklat den beskrivas som ett snabbt, enkelt sätt att finna nätverksspecifika designer och detaljer som matchar våra designdokument och best-practice för nätverkskonfigurationer till server, HCI, SDS mm.

Fabric Design Center hjälper dig modellera, designa och dokumentera en nätverksdesign för dina servrar och kluster. Den genererar till och med installationsfiler med switch-cli eller Ansible som du kan använda, inte bara vid installation, utan också för att snabbt se om dina inställningar för t.ex. MTU-size eller ROCE RDMA matchar vår best practice. Tjänsten hittar du här: http://fdc.dell.com

Även nästa tjänst kan ge insikt i nätverket. Den är inte begränsad till en enskild del av datacentret.

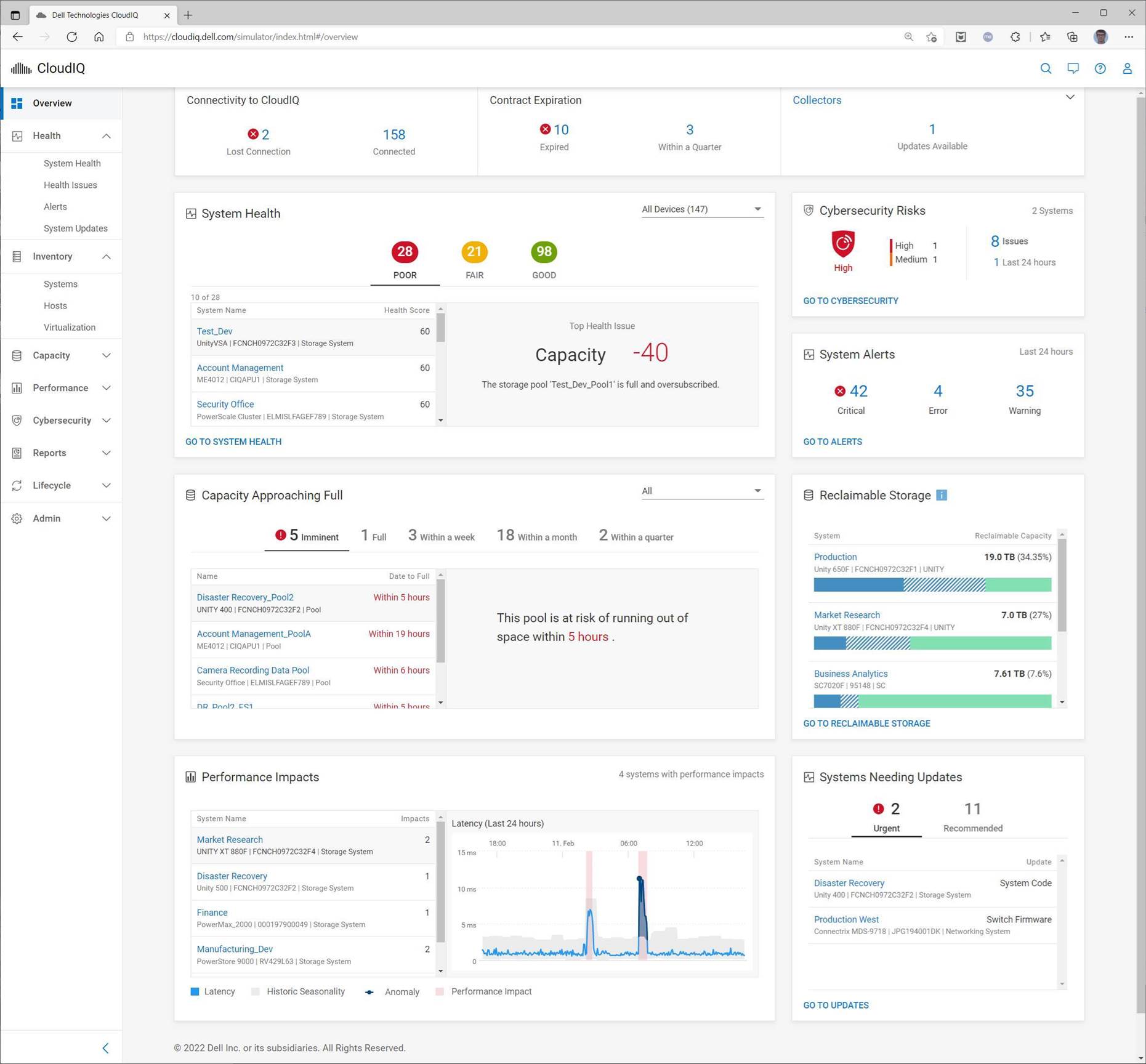

CloudIQ startade som en tjänst för lagringshantering. Idag är den en komplett insiktsportal för hela datacenterportföljen från Dell med dashboards, proaktiv övervakning, notifieringar och rekommendationer på åtgärder. Den fungerar även som en ”modern spåkula” med AI-drivna prediktiva analyser. Målet är att kombinera administratörens kompetens och AI för ökad effektivitet och minskad risk.

Anm. Fabric Design Center är tillgängligt för kunder och partners utan kostnad. CloudIQ är en tilläggstjänst som kan aktiveras kostnadsfritt för datacenterutrustning från Dell med aktivt servicekontrakt.